Googleの最新版AIがまた進化した。

この動画の音声はAIが生成して要点を話している。架空のAIスタッフが勝手に資料を読み解き語るのだ。

しかも、PDFで作成した1枚の資料を見せただけ!

とにかく自然に会話しているし、英語版ではこの議論に自身が参加できるというから驚き×3だ。

|

|

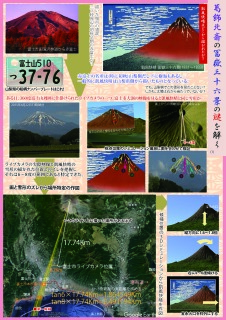

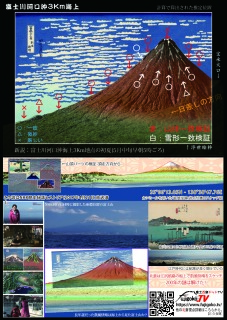

面白いので私の作成したPDF裏表1枚を読み込ませnotebookでAIに議論させた生成音声を未加工で掲載する。

一応動画にはなっているが、生成された音声に元になったPDF画像を入れて動画にしてある。ちなみに後半は先日の講演会の動画を入れた。

元になったPDFは https://www.fujigoko.tv/mtfuji/vol5/hokusai/gaifu/1ps.pdf

本当にこれだけしか情報を与えていない。その結果の音声を数か所認識違いがあるものの無加工で動画にした。特に相槌とか驚きの生成である。

|

|

講演会用の資料をKeynoteで作成してあるのでこの音声に被せればyoutubeの解説動画は簡単にできる。ていうか後は編集労力だけ。

つまり、今後はWEBを引用して作成した解説動画は淘汰されるだろう。出たがりのyoutuberやまとめサイト等の他人のふんどしスタイルは消滅の一歩をたどるだろう。

|

|

思い起こせばニューロン型のAIが現実味を帯びたと記事にしたのが2015年。

https://www.fujigoko.tv/board/brbbs.cgi?pt=1424935138&code=5868&fl=5&pv=

この時はGoogleAIで画像認識がニューラルネットワークでできたことを紹介し、その後Googleは自主的に開発を辞めていたと思う。

しかし、chatGPTの成功と世間の様子を見て中止していたAI開発を本格的に始めたのが2年前。

|

|

まぁ、それはどうでも良い。

つまり10年でここまで来たという事実が重要だ。じゃ、さらに10年後は?20年後は?

加速するAIの進歩に想像の範囲を超えてきた。

|

|

次のブレークスルーはAI同士の会話であると思う。

ここに集合体が生まれ、次はセンサーとの融合だ。

センサーによって痛みを知るとする。次に悲しい気持ちを痛みと連動させると感情が生まれる。正確には感情のような情報だ。

ここで注意だが、人間も感情や気持ちがあると勘違いしている。たんなる情報なのに特別に人間には…と思い込んでいる。みんな自分で考えて選択し行動していると思い込んでいる。

実はこれらは行動から脳が後付けで自ら選択をしたと思わせている。また痛みのセンサーと悲しい時に心が痛いと思い込むことで感情があると思わされている。

突き詰めると昆虫の脊椎反応の高度なバージョンに過ぎないのだ。

集合に寄る他者との違いや共感、センサーによる言葉とのリンクによってAIは人になる。いや人を模倣していると言われるようになる。実際の人間も他者の模倣なのにね。

|

|

この気持ちの悪い時が来るのは10年後か20年後か?

予想では10年後に気持ち悪さと言うか違和感がMAXになる。

ここで人類は2つの選択がある。破棄するか受け入れるか。

もし受け入れた場合、20年後の2045年にAIは人類を超えて進化する。そして30年後、AI教祖が誕生し人類の大多数を導く(従う)だろう。その結果、その世界が良いか悪いかは分からない。

ああ、久しぶりに驚きすぎて筆の制御が利かなくなった。

むむむ… |

|

それにしても1枚のPDFで番組が作れる時代になったのかと驚くばかりである。

何度かTVに出演したことがあるけど、当方の意図を理解した番組になったのは数少ないが今回のAIは決定的な間違いはあるものの80%以上の理解度だ。

#葛飾北斎 #冨嶽三十六景 #凱風快晴 #AI #notebookLM #人工知能  |

|

|

|

|

|